سال 2035 است و هوش مصنوعی در همه جا وجود دارد. سیستمهای هوش مصنوعی بیمارستانها را اداره میکنند، خطوط هوایی را کنترل میکنند و در دادگاه با یکدیگر کلنجار میروند. بازدهی به سطوح بیسابقهای رسیده است و تعداد بیشماری کسبوکار که موجودیت آنها قبلاً غیرقابل تصور بود با سرعتی بیسابقه افزایش یافتهاند و پیشرفتهای عظیمی در عرصه رفاه ایجاد کردهاند. محصولات جدید، درمانها و نوآوریها هر روز به بازار میآیند، زیرا علم و فناوری در حال افزایش هستند. و با این حال، جهان هم غیرقابل پیشبینیتر و هم شکنندهتر میشود، زیرا تروریستها راههای جدیدی را برای تهدید جوامع با سلاحهای سایبری هوشمند و در حال تکامل پیدا میکنند و کارگران یقه سفید (کارمندان اداری در مقابل کارگران یدی) بطور دستهجمعی شغل خود را از دست میدهند.

همین یک سال پیش، این سناریو کاملاً تخیلی به نظر می رسید. امروز، تقریباً اجتناب ناپذیر به نظر می رسد. سیستمهای هوش مصنوعی مولد در حال حاضر میتوانند واضحتر و متقاعدکنندهتر از بسیاری از انسانها بنویسند و میتوانند تصاویر، هنر و حتی کدهای کامپیوتری اصلی را بر اساس پیامهای به زبان ساده تولید کنند. هوش مصنوعی مولد فقط نوک کوه یخ است. ورود آن مانند لحظه انفجار بزرگ (Big Bang) است، آغاز یک انقلاب تکنولوژیکی در جهان در حال تغییر که روابط سیاسی، اقتصادی و اجتماعی را بازتعریف خواهد کرد.

مانند امواج تکنولوژیکی در گذشته، هوش مصنوعی رشد و فرصتهای فوقالعاده را با اختلالات و ریسکهای عظیم همراه میکند. اما بر خلاف امواج سابق، تغییر عظیمی در ساختار و توازن قدرت جهانی نیز آغاز خواهد شد زیرا موقعیت دولت-ملت ها به مثابه بازیگران اصلی ژئوپلیتیک جهان را تهدید می کند. چه آنها بپذیرند و چه نپذیرند، خالقان هوش مصنوعی خود بازیگران ژئوپلیتیکی هستند و تسلط آنها بر هوش مصنوعی بیش از پیش نظم نوظهور «تکنولوژی محور - technopolar» را تحت تاثیر قرار میدهد - نظمی که در آن شرکت های فناوری از نوعی قدرت برخوردارند که زمانی برای دولت-ملت ها محفوظ بود. در دهه گذشته، شرکتهای بزرگ فناوری عملاً به بازیگران مستقل و قدرقدرتی در حوزههای دیجیتالی که ایجاد کردهاند تبدیل شدهاند. هوش مصنوعی این روند را تسریع می کند و آن را بسیار فراتر از دنیای دیجیتال گسترش می دهد. پیچیدگی فناوری و سرعت پیشرفت آن، وضع قوانین متناسب با سرعت پیشرفت فناوری را برای دولت ها تقریباً غیرممکن می کند. اگر دولت ها این ضعف را هر چه زودتر جبران نکنند، این امکان وجود دارد که هرگز نتوانند.

خوشبختانه، سیاست گذاران در سراسر جهان شروع به بیدار شدن در مقابل چالش های ناشی از هوش مصنوعی کرده اند و با نحوه اداره آن دست و پنجه نرم می کنند. در ماه مه 2023، سازمان بین دولتی G-7 «فرآیند هوش مصنوعی هیروشیما - Hiroshima AI Process» را راهاندازی کرد، گردهمایی که به هماهنگ اداره کردن هوش مصنوعی اختصاص داشت. در ماه ژوئن، پارلمان اروپا پیش نویس قانون هوش مصنوعی اتحادیه اروپا را تصویب کرد. و این اولین تلاش جامع اتحادیه اروپا برای ایجاد امنیت در مقابل صنعت هوش مصنوعی بود. و در ماه ژوئیه، آنتونیو گوترش، دبیر کل سازمان ملل متحد، خواستار ایجاد یک ناظر نظارتی جهانی هوش مصنوعی شد. در همین حال، در ایالات متحده، سیاستمداران هر دو حزب اصلی خواستار اقدامات نظارتی هستند. اما بسیاری با تد کروز، سناتور جمهوریخواه تگزاس موافقند، که در ژوئن به این نتیجه رسید که کنگره «نمیداند دارد چه میکند».

متأسفانه، بسیاری از بحث ها در مورد نحوه اداره هوش مصنوعی همچنان در یک چرخه خطرناک گیر افتاده است: استفاده از هوش مصنوعی برای گسترش اقتدار ملی یا محدود کردن آن برای جلوگیری از خطرات آن. حتی کسانی که به طور دقیق مشکل را تشخیص میدهند، سعی میکنند معضل را با استفاده از هوش مصنوعی در چارچوبهای موجود یا سابقا موجود حل کنند. هوش مصنوعی مفاهیم سنتی قدرت ژئوپلیتیک را تغییر داده است و نمی تواند مانند هر فناوری سابق اداره شود.

چالش واضح است: طراحی چارچوب مدیریتی جدید متناسب با این فناوری منحصر به فرد. اگر قرار است مدیریت جهانی هوش مصنوعی ممکن شود، سیستم بینالمللی باید از مفاهیم سنتی مدیریتی گذشته فاصله گرفته و پذیرای شرکتهای فناوری شود. این بازیگران ممکن است مشروعیت خود را از یک قرارداد اجتماعی، دموکراسی یا ارائه کالاهای عمومی به دست نیاورند، اما بدون آنها، مدیریت موثر هوش مصنوعی شانسی نخواهد داشت. این نمونه ای از چگونگی نیاز جامعه بین المللی به بازنگری در مفروضات اساسی در مورد نظم ژئوپلیتیکی است. اما تنها این مورد نیست.

چالش نادر و مبرم هوش مصنوعی نیازمند یک راه حل اساسی است. قبل از اینکه سیاستگذاران بتوانند ساختار نظارتی مناسب را تدوین کنند، باید در مورد اصول اساسی نحوه اداره آن به توافق برسند. برای شروع، هر چارچوب مدیریتی باید هشیارانه، فراگیر، شفاف و هدفمند باشد. با تکیه بر این اصول، سیاست گذاران باید همزمان حداقل سه نظام همپوشان ایجاد کنند: یکی برای حقیقت یابی و مشاوره به دولت ها در مورد خطرات ناشی از هوش مصنوعی، دیگری برای جلوگیری از یک مسابقه تسلیحاتی همه جانبه بین کشورها، و دیگری برای مدیریت نیروهای مخرب یک تکنولوژی متفاوت از آنچه که دنیا تا کنون به خود دیده است.

چه بخواهیم و چه نخواهیم، 2035 در راه است. این که آیا آینده با پیشرفت های مثبت منتج از هوش مصنوعی تعریف شود یا با اختلالات منفی ناشی از آن، بستگی به این دارد که سیاست گذاران در حال حاضر چه اقدامی انجام میدهند.

سریعتر، متکامل تر، قویتر

هوش مصنوعی متفاوت از سایر فناوریهاست و تأثیر آن بر قدرت نیز متفاوت است. هوش مصنوعی تنها چالش های مربوط به سیاست را ایجاد نمی کند. ماهیت فوق تکاملی آن نیز حل آن چالش ها را سخت تر می کند واین پارادوکس قدرت هوش مصنوعی است.

سرعت پیشرفت خیره کننده است. قانون مور (Moore’s Law) را در نظر بگیرید که با موفقیت دو برابر شدن قدرت محاسباتی را هر دو سال یک بار پیش بینی کرده است. موج جدید هوش مصنوعی باعث می شود که این میزان پیشرفت شگفت انگیز به نظر برسد. هنگامی که OpenAI (آزمایشگاه تحقیقاتی هوش مصنوعی آمریکایی) اولین مدل بزرگ زبانی خود را به نام GPT-1 در سال 2018 راه اندازی کرد، دارای 117 میلیون پارامتر بود که اندازه گیری مقیاس و پیچیدگی سیستم است. پنج سال بعد، تصور میشود که نسل چهارم مدل این شرکت، GPT-4، بیش از یک تریلیون پارامتر داشته باشد. میزان محاسباتی که برای آموزش قویترین مدلهای هوش مصنوعی استفاده میشود، در ده سال گذشته هر سال ده برابر افزایش یافته است. به عبارت دیگر، پیشرفتهترین مدلهای هوش مصنوعی امروزی – که پیشرفته ترین مدلها «frontier» نیز شناخته میشوند، پنج میلیارد برابر قدرت محاسباتی مدلهای پیشرفته یک دهه پیش را دارا هستند. پردازشی که زمانی هفته ها طول می کشید، اکنون در چند ثانیه انجام می شود. مدلهایی که میتوانند دهها تریلیون پارامتر را مدیریت کنند در چند سال آینده عرضه میشوند. مدلهای «مقیاس مغز – brain scale» با بیش از 100 تریلیون پارامتر - تقریباً تعداد سیناپسها (محل تماس دو عصب) در مغز انسان - ظرف پنج سال قابل اجرا خواهند بود.

با هر پیشرفت جدید، قابلیت های غیرمنتظره ای ظاهر می شوند. تعداد کمی پیشبینی میکردند که آموزش بر روی متن خام، مدلهای بزرگ زبانی را قادر میسازد تا جملات منسجم، بدیع و حتی خلاقانه تولید کنند. تعداد کمتری میتوانند تصور کنند که مدل های زبانی بتوانند موسیقی تولید کنند یا مشکلات علمی را حل کنند، همانطور که برخی اکنون می توانند. بهزودی، توسعهدهندگان هوش مصنوعی احتمالاً موفق خواهند شد سیستمهایی با قابلیتهای خود-بهبود (self-improving) تولید کنند، که نقطه عطفی در مسیر این فناوری خواهد بود و همه را شگفت زده خواهد کرد.

مدلهای هوش مصنوعی با کمترین هزینه بیشترین بازدهی را تولید میکنند. قابلیتهای پیشرفته دیروز، امروز با سیستمهای کوچکتر، ارزانتر و در دسترستر اجرا میشوند. تنها سه سال پس از انتشار GPT-3 OpenAI (Generative Pre-trained Transformer 3)، تیمهای "مرجع در دسترس" ( Open Sourceکد مرجعی است که به صورت رایگان برای تغییرات احتمالی و توزیع مجدد در دسترس است) مدلهایی با همان سطح کارایی را ایجاد کردند که شصت برابر کوچکتر است - یعنی 60 برابر ارزانتر برای اجرا در تولید، کاملا رایگان، و در اینترنت برای همه در دسترس است. مدلهای بزرگ زبان آینده احتمالاً این مسیر کارآمدی را دنبال خواهند کرد و تنها دو یا سه سال پس از صرف صدها میلیون دلار از سوی آزمایشگاههای پیشرو هوش مصنوعی برای توسعه آنها، به صورت مرجع در دسترس در دسترس خواهند بود.

همانند هر نرم افزار یا کد دیگری، الگوریتم های هوش مصنوعی نسبت به اموال منقول بسیار آسان تر و ارزان تر تکثیر و به اشتراک (یا سرقت) گذاشته میشوند. خطرات تکثیر آشکار است. به عنوان مثال، مدل قدرتمند متا، Llama-1، چند روز پس از عرضه در ماه مارس به اینترنت درز کرد. اگرچه قویترین مدلها هنوز برای کار کردن به سختافزار پیچیده نیاز دارند، نسخههای متوسط میتوانند روی رایانههایی اجرا شوند که میتوان آنها را با قیمت چند دلار در ساعت اجاره کرد. به زودی چنین مدل هایی روی گوشی های هوشمند اجرا خواهند شد. هیچ فناوری به این قدرتمندی به این سرعت در دسترس نبوده است.

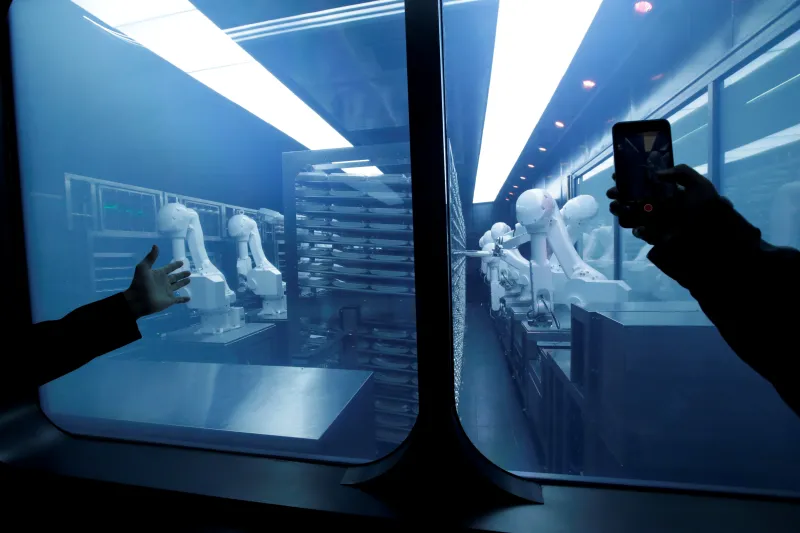

ربات ها در حال تهیه غذا در یک رستوران هات پات در پکن، نوامبر 2018

هوش مصنوعی همچنین با فناوریهای قدیمیتر از این جهت متفاوت است. تقریباً میتوان همه آن را به عنوان «کاربرد دوگانه» نظامی و غیرنظامی توصیف کرد. بسیاری از سیستم ها ذاتا دارای کاربرد فراگیر هستند و در واقع، فراگیر بودن هدف اصلی بسیاری از شرکت های هوش مصنوعی است. آنها میخواهند برنامههای کاربردیشان به بیشترین تعداد ممکن از مردم کمک کند. اما همان سیستم هایی که ماشین ها را هدایت می کنند می توانند تانک ها را نیز هدایت کنند. یک برنامه کاربردی هوش مصنوعی که برای تشخیص بیماری ها ساخته شده است، ممکن است بتواند برنامه جدیدی ایجاد و به سلاح تبدیل کند. مرزهای بین کاربردهای امن غیر نظامی و مخرب نظامی ذاتا مبهم است. و این تا حدی توضیح می دهد که چرا ایالات متحده صادرات پیشرفته ترین نیمه هادی ها را به چین محدود کرده است.

همه اینها در گستره جهانی انجام می شود: پس از انتشار، مدل های هوش مصنوعی می توانند در همه جا وجود داشته باشند. و فقط یک مدل مخرب برای ویران کردن در مقیاس عظیم لازم است. به همین دلیل، تنظیم و مدیریت هوش مصنوعی نمی تواند به صورت مجزا انجام شود. اگر در برخی کشورها هوش مصنوعی مهار نشود، تنظیم و مدیریت آن در دیگر کشورها کاربرد چندانی ندارد. از آنجایی که هوش مصنوعی می تواند به راحتی تکثیر شود، مدیریت و کنترل آن هیچ مرزی را نمیشناسد.

علاوه بر این، آسیبهایی که هوش مصنوعی ممکن است وارد کند، حتی با افزایش انگیزههای ساخت آن (و مزایای انجام آن) هیچ محدودیتی ندارد. هوش مصنوعی می تواند برای تولید و گسترش اطلاعات نادرست مخرب، از بین بردن اعتماد اجتماعی و دموکراسی ازقبیل زیر نظر گرفتن، کلاهبرداری و تحت سلطه در آوردن شهروندان، تضعیف آزادی فردی و اجتماعی؛ یا ایجاد سلاح های دیجیتال یا فیزیکی قدرتمند که جان انسان ها را تهدید می کند استفاده شود. هوش مصنوعی همچنین میتواند میلیونها شغل را از بین ببرد، نابرابریهای موجود را تشدید و مشاغل جدید ایجاد کند، الگوهای تبعیض آمیز را تثبیت کند و با تقویت حلقه های بازخورد اطلاعات بد، تصمیم گیری را تحریف کند، یا باعث تنش ناخواسته و غیرقابل کنترل نظامی منجر به جنگ شود.

همچنین چارچوب زمانی برای بزرگترین خطرات مشخص نیست. اطلاعات غلط آنلاین یک تهدید کوتاه مدت آشکار است، همانطور که جنگ بدون کنترل در میان مدت محتمل به نظر می رسد. در آینده دورتر، خطر اینکه هوش مصنوعی در هر مورد معین از عملکرد انسان فراتر رود، و خطر اینکه (مسلماً حدس و گمان) AGI (Artificial General Intelligence) خارج از کنترل انسان بطور اتوماتیک هدایت شود، تکرار شود و خود را بهبود بخشد، نهفته است. همه این خطرات باید از همان ابتدا در معماری اداره و کنترل هوش مصنوعی لحاظ شود.

هوش مصنوعی اولین فناوری با برخی از این ویژگی های قوی نیست، اما اولین فناوری است که ترکیبی از همه آنهاست. سیستمهای هوش مصنوعی مانند اتومبیلها یا هواپیماها نیستند که بر روی سختافزار با پیشرفتهای تدریجی ساخته شدهاند و پرهزینهترین خرابیهای آنها به صورت تصادفات مجزا رخ میدهد. آنها مانند سلاح های شیمیایی یا هسته ای نیستند که توسعه و نگهداری آنها دشوار و پرهزینه است، چه رسد به اشتراک گذاری یا استقرار مخفیانه آنها. همانطور که مزایای عظیم آنها بدیهی است، سیستم های هوش مصنوعی تنها بزرگتر، بهتر، ارزان تر و در همه جا قابل دسترسی خواهند بود. آنها حتی قادر خواهند بود بطور خودکار، قادر به دستیابی به اهداف مشخص با حداقل نظارت انسانی و به طور بالقوه قادر به به روز کردن خود باشند. هر یک از این ویژگیها مدلهای اداره و کنترل کردن به شیوه سنتی را به چالش میکشد. همه این ویژگیها دست به دست هم داده و مدل های سنتی را به طرز ناامیدکننده ای ناکافی جلوه میدهند.

آنقدر قدرتمند است که جای درنگ و تردید باقی نمیگذارد

گویی این کافی نبود، هوش مصنوعی با تغییر ساختار و توازن قدرت جهانی، زمینه سیاسی کنترل و اداره کردن خود را پیچیده میکند. هوش مصنوعی فقط توسعه نرم افزار نیست بلکه یک ابزار کاملاً جدید برای برنامه ریزی و پیش بینی قدرت است. در برخی موارد، میتواند مقامات در قدرت را کله پا کند و در مواردی آنها را تثبیت و تقویت کند. علاوه بر این، پیشرفت آن با انگیزههای وسوسه انگیز صورت میگیرد وهر ملت، شرکت و فردی گونه خاصی از آنرا میخواهد.

در کشورها، هوش مصنوعی به کسانی که از آن برای نظارت، فریب و حتی کنترل جمعیت از قبیل جمعآوری و استفاده تجاری از دادههای شخصی در دموکراسیها و تشدید کردن ابزارهای سرکوبی که دولتهای مستبد برای تحت سلطه در آوردن جوامع خود استفاده میکنند، قدرت میدهد. در بین کشورها، هوش مصنوعی کانون رقابت شدید ژئوپلیتیکی خواهد بود. برتری هوش مصنوعی چه به دلیل قابلیتهای سرکوبکننده، پتانسیل اقتصادی یا برتری نظامی، هدف استراتژیک هر دولتی با توانایی رقابت خواهد بود. استراتژی های کمتر قابل تصور پول را به تلاش گران بومی هوش مصنوعی پمپ می کنند یا سعی می کنند ابررایانه ها و الگوریتم ها را تولید و کنترل کنند. فرانسه با حمایت مستقیم از استارتآپهای هوش مصنوعی، بریتانیا با سرمایهگذاری در سیستم آموزش عالی خود و سرمایهگذاری خطرپذیر خود در اکوسیستم؛ و اتحادیه اروپا، با شکل دادن به گفتگوی جهانی در مورد مقررات و هنجارها، باعث میشوند استراتژیهای ظریفتر مزیتهای رقابتی خاصی را تقویت کنند.

اکثریت قریب به اتفاق کشورها نه پول و نه دانش فنی لازم برای رقابت دردست بالا داشتن در هوش مصنوعی را دارند. دسترسی آنها به پیشرفته ترین مدل هوش مصنوعی در عوض با روابط آنها با تعداد انگشت شماری از شرکت ها و دولت های ثروتمند و قدرتمند تعیین می شود. این وابستگی تهدیدی برای تشدید عدم تعادل قدرت ژئوپلیتیک فعلی است. قدرتمندترین دولتها برای کنترل ارزشمندترین منابع جهان رقابت خواهند کرد، در حالی که باز هم، کشورهای جنوب جهانی عقب خواهند ماند. این بدان معنا نیست که فقط ثروتمندترین ها از انقلاب هوش مصنوعی سود می برند. مانند اینترنت و گوشیهای هوشمند، هوش مصنوعی بدون رعایت مرزها و همچنین دستاوردهای بهرهوری که از آن آزاد میشود، تکثیر میشود. و مانند انرژی و فناوری سبز، هوش مصنوعی برای بسیاری از کشورهایی که آن را کنترل نمی کنند، از جمله کشورهایی که در تولید داده های هوش مصنوعی مانند نیمه هادی ها مشارکت دارند، سود خواهند برد.

با این حال، از طرف دیگر، رقابت برای برتری هوش مصنوعی شدید خواهد بود. در پایان جنگ سرد، کشورهای قدرتمند ممکن بود برای رفع ترس طرف مقابل و توقف یک مسابقه تسلیحاتی بیثبات کننده بالقوه همکاری کنند. اما محیط پرتنش ژئوپلیتیک امروزی این همکاری را بسیار سخت تر می کند. هوش مصنوعی تنها ابزار یا سلاح دیگری نیست که بتواند اعتبار، قدرت یا ثروت به ارمغان بیاورد. این پتانسیل را دارد که برتری نظامی و اقتصادی قابل توجهی را نسبت به رقبا ایجاد کند. به درست یا نادرست، دو بازیکنی که بیشترین اهمیت را دارند - چین و ایالات متحده - هر دو توسعه هوش مصنوعی را یک بازی با مجموع صفر می دانند که به برنده یک برتری استراتژیک تعیین کننده در دهه های آینده خواهد داد. (بازی حاصل جمع صفر - Zero-sum game - نمایشی ریاضی در تئوری بازی ها و تئوری اقتصادی وضعیتی است که دو طرف را در بر می گیرد که نتیجه آن برای یک طرف سود و برای طرف دیگر ضرری معادل دارد. به عبارت دیگر، سود بازیکن یک معادل ضرر بازیکن دو است، در نتیجه بهبود خالص در سود بازی صفر است. اگر مجموع سود شرکتکنندگان جمع شود و مجموع ضررها از آن کم شود، مجموع آنها صفر میشود.)

از نقطه نظر واشنگتن و پکن، خطر اینکه طرف مقابل در هوش مصنوعی برتری پیدا کند، بیشتر از هر خطر نظری است که فناوری ممکن است برای جامعه یا اقتدار سیاسی داخلی آنها ایجاد کند. به همین دلیل، دولت های ایالات متحده و چین منابع عظیمی را برای توسعه قابلیت های هوش مصنوعی سرمایه گذاری می کنند و در عین حال تلاش می کنند یکدیگر را از داده های مورد نیاز برای پیشرفت های بعدی محروم کنند. (تا کنون، ایالات متحده در انجام دومی بسیار موفق تر از چین بوده است، به ویژه با کنترل صادرات خود بر روی نیمه هادی های پیشرفته). این بازی حاصل جمع صفر - و عدم اعتماد هر دو طرف - به این معنی است که پکن و واشنگتن به جای کاهش سرعت توسعه هوش مصنوعی بر سرعت بخشیدن به توسعه آن متمرکز هستند. از نظر آنها، "مکث" در توسعه برای ارزیابی خطرات، همانطور که برخی از دست اندرکاران صنعت هوش مصنوعی خواستار آن شده اند، به منزله خلع سلاح احمقانه یکجانبه است.

اما این دورنما فرض میکند که دولتها میتوانند حداقل مقداری کنترل بر هوش مصنوعی داشته باشند. این فرض ممکن است در مورد چین که شرکت های فناوری خود را در ساختار دولت ادغام کرده است صادق باشد. اما در غرب و جاهای دیگر، هوش مصنوعی به احتمال زیاد قدرت دولت را تقویت نمکیند بلکه تضعیف می کند. در خارج از چین، تعدادی از شرکتهای بزرگ و متخصص هوش مصنوعی در حال حاضر همه جنبههای این موج فناوری جدید را کنترل میکنند: مدلهای هوش مصنوعی چه کاری میتوانند انجام دهند، چه کسی میتواند به آنها دسترسی داشته باشد، چگونه میتوان از آنها استفاده کرد و در کجا میتوان آنها را مستقر کرد. و از آنجایی که این شرکتها با هشیاری از قدرت محاسباتی و الگوریتمهای خود محافظت میکنند، تقریبا تنها آنها میدانند چه تکنولوژی تولید میکنند و چه کارهایی میتوانند انجام دهند. این چند شرکت ممکن است برتری خود را برای آینده قابل پیشبینی حفظ کنند یا ممکن است تحت الشعاع تعداد زیادی از بازیگران کوچکتر قرار بگیرند، زیرا موانع کم برای ورود، توسعه گسترده و هزینههای حاشیهای نردیک به صفر منجر به تکثیر کنترلنشده هوش مصنوعی میشود. در هر صورت، تحول هوش مصنوعی خارج از دولت اتفاق خواهد افتاد.

تا حدی محدود، برخی از این چالش ها به چالش های فناوری های دیجیتال قبلی شباهت دارند. پایگاههای اینترنتی، رسانههای اجتماعی، و حتی دستگاههایی مانند گوشیهای هوشمند، همگی تا حدی در چارچوب هایی که توسط سازندگانشان کنترل میشوند، کار میکنند. هنگامی که دولت ها بر اساس ضرورت سیاسی اراده کردند، توانستند سیستم های نظارتی مانند مقررات حفاظت از داده های عمومی اتحادیه اروپا، قانون بازارهای دیجیتال و قانون خدمات دیجیتال را برای این فناوری ها ایجاد کنند. اما اجرای چنین مقرراتی در اتحادیه اروپا یک دهه یا بیشتر طول کشید و هنوز به طور کامل در ایالات متحده تحقق نیافته است. هوش مصنوعی خیلی سریع متحول می شود تا جایی که سیاست گذاران قادر نیستند متناسب با آن واکنش نشان دهند. علاوه بر این، رسانههای اجتماعی و دیگر فناوریهای دیجیتال قدیمیتر به تولید خود کمکی نمیکنند، و انگیزه های تجاری و استراتژیک پیش برنده آنها هرگز به یک شکل یکسان نبود: توییتر و تیکتاک قدرتمند هستند، اما کمتر کمی فکر میکند که میتوانند اقتصاد جهانی را متحول کنند.

همه اینها بدان معنی است که حداقل برای چند سال آینده، صرف نظر از اینکه سیاست گذاران در بروکسل یا واشنگتن چه می کنند، مسیر هوش مصنوعی تا حد زیادی توسط تصمیمات تعداد انگشت شماری از شرکتهای خصوصی تعیین می شود. به عبارت دیگر، فنآوران، نه سیاستگذاران یا بوروکراتها، بر نیرویی اعمال قدرت خواهند کرد که میتواند هم قدرت ملت-دولتها و هم نحوه ارتباط آنها با یکدیگر را تغییر دهد. این باعث میشود که چالش مدیریت و کنترل هوش مصنوعی، به مثابه یک قانون نظارتی ظریفتر و با ریسکهای بیشتر در مقایسه با هر اقدامی که سیاستگذاران اتخاذ کرده اند، متفاوت از هر چالشی که دولتها تا کنون با آن روبرو بودهاند باشد.

هدف تکان دهنده، سلاح نوظهور

دولت ها در حال حاضر از قافله عقب مانده اند. اکثر طرحهای پیشنهادی برای مدیریت و کنترل هوش مصنوعی، آن را بهعنوان یک مشکل متعارف در نظر میگیرند که با راهحلهای دولتمحور قرن بیستم سازگار است - مثلا توافقاتی بر سر قوانینی که توسط رهبران سیاسی که دور یک میز نشستهاند، حاصل میشود. اما این رویکرد در مورد هوش مصنوعی کارساز نخواهد کرد.

تلاشهای نظارتی تا به امروز در مراحل ابتدایی خود هستند و هنوز کافی نیستند. قانون هوش مصنوعی اتحادیه اروپا بلندپروازانهترین تلاش برای اداره هوش مصنوعی در هر قلمرویی است، اما این قانون تنها از سال 2026 به طور کامل اعمال میشود و تا آن زمان مدلهای هوش مصنوعی فراتر از تصور پیشرفت خواهند کرد. بریتانیا یک رویکرد آزادتر و داوطلبانه را برای نظارت بر هوش مصنوعی پیشنهاد کرده است، اما فاقد قابلیت برای موثر بودن است. هیچ یک از این ابتکارات برای مدیریت توسعه و استقرار هوش مصنوعی در سطح جهانی تلاشی ندارد - امری که برای موفقیت نظارت و مدیریت هوش مصنوعی ضروری است. و در حالی که تعهدات داوطلبانه برای احترام به دستورالعملهای ایمنی هوش مصنوعی، مانند آنچه در ماه ژوئیه توسط هفت توسعهدهنده پیشرو هوش مصنوعی، از جمله شرکت هوش مصنوعی (Inflection AI)، به رهبری یکی از ما (سلیمان)، انجام شد، مورد استقبال قرار میگیرد، اما هیچکدام به لحاظ قانونی جایگزینی برای مقررات الزام آور در سطوح ملی و بینالمللی نیست.

طرفداران توافقات در سطح بین المللی برای مهار هوش مصنوعی تمایل دارند به مدلی مانند مدل کنترل تسلیحات هسته ای دست یابند. اما گسترش، سرقت و تکثیر کردن سیستم های هوش مصنوعی نه تنها از سلاح های هسته ای بسیار آسان تر است بلکه آنها توسط شرکت های خصوصی کنترل می شوند و نه دولت ها. از آنجایی که نسل جدید مدلهای هوش مصنوعی سریعتر از همیشه منتشر میشوند، مقایسه آن با مدل هستهای مقایسه مع الفارق به نظر میرسد. حتی اگر دولتها بتوانند با موفقیت دسترسی به مواد مورد نیاز برای ساخت پیشرفتهترین مدلها را کنترل کنند - همانطور که دولت بایدن با جلوگیری از دستیابی چین به تراشههای پیشرفته تلاش میکند تا این کار را انجام دهد - پس از تولید، نمیتوانند جلوی تکثیر این مدلها را بگیرند.

برای اینکه مدیریت و نظارت جهانی بر هوش مصنوعی کار کند، باید با ماهیت خاص فناوری، چالشهایی که ایجاد میکند و ساختار و توازن قدرتی که در آن عمل میکند، هماهنگ شود. اما از آنجایی که تکامل، کاربردها، خطرات و مزیتهای هوش مصنوعی غیرقابل پیشبینی است، نمیتوان در ابتدا یا در هر مقطع زمانی، مدیریت هوش مصنوعی را به طور کامل مشخص کرد. مدیریت هوش مصنوعی باید به اندازه فناوری که به دنبال مدیریت آن است خلاق و تکامل یابنده باشد و در وهله اول دارای برخی از ویژگیهایی باشد که هوش مصنوعی را به چنین نیروی قدرتمندی تبدیل میکند. این به معنای آغازی نو، بازاندیشی و بازسازی یک چارچوب نظارتی جدید از پایه است.

هدف اساسی و فراگیر هر ساختار نظارتی هوش مصنوعی جهانی باید شناسایی و کاهش خطرات در راستای ثبات جهانی بدون ایجاد مانع در فرایند نوآوری هوش مصنوعی و فرصتهای ناشی از آن باشد. بگذارید این رویکرد را «پیشگیری یا احتیاط گرایی تکنولوژیکی - technoprudentialism» بنامیم، موردی که بیشتر شبیه نقش پیشگیرانه کلان نهادهای مالی جهانی مانند هیئت ثبات مالی (Financial Stability Board-FSB)، بانک تسویه حسابهای بینالمللی (Bank for International SettlementsیاBIS) و صندوق بینالمللی پول (International Monetary Fund (IMF)) است. هدف این نهادها شناسایی و کاهش خطرات برای ثبات مالی جهانی بدون به خطر انداختن رشد اقتصادی است. (پیشگیری یک اصل اخلاقی مبتنی بر اصول احتیاطی است که برای جلوگیری از تأثیر منفی خاص عمل می کند.)

نگهبانان در کنفرانس هواوی در شانگهای، سپتامبر 2019

رویکرد پیشگیرانه در عرصه هوش مصنوعی نیز به همین شکل عمل میکند و ایجاد مکانیسمهای نهادی برای مورد توجه قرار دادن جنبههای مختلف هوش مصنوعی که میتواند ثبات ژئوپلیتیکی را تهدید کند، ضروری است. این مکانیسمها به نوبه خود توسط اصول مشترکی هدایت میشوند که هم بر اساس ویژگیهای منحصربهفرد هوش مصنوعی طراحی شدهاند و هم منعکسکننده تعادل فناوری جدید قدرت هستند که شرکتهای فناوری را در موقعیت نیروی پیش برنده قرار داده است. این اصول به سیاستگذاران کمک میکند تا چارچوبهای نظارتی دقیقتری برای مدیریت هوش مصنوعی در حال تکامل و تبدیل شدن به یک نیروی فراگیرتر، ترسیم کنند.

اولین و شاید حیاتی ترین اصل مدیریت هوش مصنوعی، پیشگیری است. همانطور که از این اصطلاح پیداست، فنآوری در هستهی خود با باور پیشگیرانه " قبل از هر چیز، آسیبی نرسانید " هدایت میشود. محدود کردن حداکثری هوش مصنوعی به معنای محدود کردن جنبههای مثبت تاثیرکذار آن در زندگی است، اما آزادسازی حداکثری آن به معنای به آزادسازی تمام جنبههای منفی بالقوه فاجعهبار آن است. به عبارت دیگر، نمای ریسک-مزیت برای هوش مصنوعی همخوانی ندارد. با توجه به عدم قطعیت در مورد مقیاس و برگشت ناپذیری برخی از آسیبهای بالقوه هوش مصنوعی، مدیریت هوش مصنوعی باید به جای کاهش دادن آنها بعد از وقوع، بر رویکرد پیشگیری متمرکز باشد. این امر به ویژه مهم است زیرا هوش مصنوعی می تواند دموکراسی را در برخی کشورها تضعیف و وضع مقررات را برای آنها دشوارتر کند. علاوه بر این، بار اثبات ایمن بودن یک سیستم هوش مصنوعی در حد معقول باید بر عهده تولید کننده و مالک آن سیستم باشد. این نباید صرفاً به عهده دولت ها باشد که به محض بروز مشکلات با آنها برخورد کنند.

مدیریت هوش مصنوعی همچنین باید سریع باشد تا بتواند مسیر خود را با تکامل و بهبود خود تطبیق داده و اصلاح کند. موسسات دولتی اغلب به حدی می رسند که قادر به انطباق با تغییرات نیستند. و در مورد هوش مصنوعی، سرعت پیشرفت فناوری ساختارهای مدیریتی موجود را برای به روز کردن خود خیلی سریع تحت فشار قرار خواهد داد. این بدان معنا نیست که مدیریت هوش مصنوعی باید خصلت سیلیکون ولی «سریع حرکت کنید و چیزها را بشکنید - move fast and break things» را اتخاذ کند، اما باید ماهیت فناوری را که به دنبال آن است با دقت بیشتری منعکس کند.

علاوه بر محتاط و سریع بودن، مدیریت هوش مصنوعی باید فراگیر باشد و از همه بازیگران لازم برای تنظیم عملی آن دعوت به همکاری کند. این بدان معناست که مدیریت هوش مصنوعی نمی تواند منحصراً دولت محور باشد، زیرا دولت ها هوش مصنوعی را نه درک می کنند و نه کنترل می کنند. شرکتهای فناوری خصوصی ممکن است فاقد استقلال و اقتدار به معنای سنتی باشند، اما در فضاهای دیجیتالی که ایجاد کردهاند و به طور مؤثر آن را مدیریت میکنند، از قدرت و اختیار واقعی، حتی استقلال، برخوردارند. این بازیگران غیردولتی نباید، نسبت به کشورهایی که در سطح بین المللی به نمایندگی از شهروندان خود به رسمیت شناخته شده اند، از حقوق و امتیازات یکسانی برخوردار شوند. اما آنها باید طرفهای نشستهای بینالمللی باشند و هر گونه توافقنامهای درباره هوش مصنوعی را امضا کنند.

چنین مدیریت فراگیری ضروری است زیرا هر ساختار نظارتی که عوامل واقعی قدرت هوش مصنوعی را نادیده بگیرد، محکوم به شکست است. در موجهای پیشین مقررات فناوری، اغلب به شرکتها آزادی عمل زیادی داده میشد که فراتر از آن عمل میکردند و باعث میشد سیاستگذاران و تنظیمکنندههای مقررات به شدت نسبت به افراط کاریهای آنها واکنش نشان دهند. اما این پویایی نه برای شرکت های فناوری و نه برای مردم سودی نداشت. دعوت از توسعهدهندگان هوش مصنوعی برای مشارکت در فرآیند قانونگذاری از همان ابتدا به ایجاد فرهنگ مشارکتیتر مدیریت هوش مصنوعی کمک میکند و نیاز به مهار این شرکتها را بعد از این واقعیت با مقررات پرهزینه و خصمانه کاهش میدهد.

شرکت های فناوری لازم نیست در همه مراحل دخیل باشند. برخی از جنبههای مدیریتی هوش مصنوعی بهتر است به دولتها واگذار شود، و ناگفته نماند که دولتها باید همیشه حق وتوی نهایی را در تصمیمگیریهای سیاسی حفظ کنند. دولتها همچنین باید در مقابل دست اندازی شرکتهای فناوری به مقررات هشیار باشند و اطمینان حاصل کنند که شرکتهای فناوری از نفوذ خود در سیستمهای سیاسی برای پیشبرد منافع خود به بهای منافع عمومی استفاده نمیکنند. اما یک مدل مدیریتی فراگیر و چند جانبه باید اطمینان حاصل کند که بازیگرانی که سرنوشت هوش مصنوعی را تعیین میکنند در فرآیندهای قانونگذاری مشارکت و متعهد به رعایت آنها باشند. علاوه بر دولت ها (به ویژه اما نه محدود به چین و ایالات متحده) و شرکت های فناوری (به ویژه اما نه محدود به بازیگران بزرگ فناوری)، دانشمندان، متخصصین علم اخلاق، اتحادیه های کارگری، نهادهای مدنی، و سایر صاحب نظران باید در این فرایند دخیل باشند. مشارکت در فرانیدهای هوش مصنوعی در قالب یک گروه غیرانتفاعی شامل طیف وسیعی از شرکتهای بزرگ فناوری، موسسات تحقیقاتی، خیریهها و نهادهای مدنی که استفاده مسئولانه از هوش مصنوعی را ترویج میکند، نمونه خوبی از نوع انجمن ترکیبی و فراگیر مورد نیاز است.

مدیریت و مقررات هوش مصنوعی نیز باید تا حد امکان غیرقابل تفسیر باشد. برخلاف کاهش تغییرات آب و هوایی، که موفقیت در آن با مجموع تمام تلاشهای فردی تعیین میشود، ایمنی هوش مصنوعی با کمترین مشارکت به دست میاید. شکست در یک الگوریتم منفرد میتواند صدمات غیر قابل تصور ایجاد کند. از آنجایی که کیفیت مدیریت جهانی هوش مصنوعی در حد بدترین مدیریت کشور، شرکت یا فناوری است، باید جامع و بی نقص باشد و ورود آن به اندازه کافی آسان باشد تا مشارکت را تشویق و خروج از آن به اندازه کافی پرهزینه باشد تا از عدم رعایت مقررات جلوگیری کند. یک نقطه ضعف در را به روی نشت گسترده اطلاعات، بازیگران بد و یا یک مسابقه نظارتی باز می کند.

علاوه بر پوشش کل جهان، مدیریت هوش مصنوعی باید کل زنجیره تامین - از تولید گرفته تا سخت افزار، نرم افزار تا خدمات، و ارائه دهندگان تا کاربران سرویس را پوشش دهد. این به معنای مقررات پیشگیرانه و نظارت فنی بر روی هر مرحله از زنجیره ارزش هوش مصنوعی، از تولید تراشههای هوش مصنوعی گرفته تا جمعآوری دادهها، آموزش مدلسازی تا استفاده نهایی، و در سراسر مجموعه فناوریهای مورد استفاده در یک برنامه خاص است. چنین مدیریتی تضمین می کند که هیچ نقطه خاکستری نظارتی برای سواستفاده کردن وجود نداشته باشد.

در نهایت، مدیریت و مقررات هوش مصنوعی باید هدفمند باشد، نه اینکه یک اندازه برای همه باشد. از آنجایی که هوش مصنوعی یک فناوری همه منظوره است، تهدیدات چند بعدی را به همراه دارد. یک ابزار مدیریتی واحد برای رسیدگی به منابع مختلف خطر هوش مصنوعی کافی نیست. در عمل، تعیین اینکه کدام ابزارها برای هدف قرار دادن کدام ریسکها مناسب هستند، مستلزم ایجاد طبقهبندی پویا و منطقی از تمام اثرات احتمالی هوش مصنوعی است - و اینکه چگونه میتوان هر کدام را به بهترین نحو کنترل کرد. به عنوان مثال، هوش مصنوعی در برخی از برنامهها تکاملی و تدریجی خواهد بود، مشکلات فعلی مانند نقض حریم خصوصی را تشدید میکند و در برخی دیگر بنیادین است و آسیبهای کاملاً جدیدی ایجاد میکند. گاهی اوقات، بهترین زمان برای مداخله، زمانی است که داده ها جمع آوری می شوند. در مواقع دیگر، زمانی است که تراشههای پیشرفته به فروش میرسند و اطمینان حاصل میشود که در اختیار ناصالحان قرار نمیگیرند. مقابله با اطلاعات اشتباه و اطلاعات به عمد غلط به ابزارهای متفاوتی در مقایسه با مقابله با خطرات هوش جامع مصنوعی (شکل پیشرفته از هوش مصنوعی است که می تواند وظایف انسانی را انجام دهد و می تواند مهارت های حسی و حرکتی، عملکرد، یادگیری و هوش انسان را تقلید کند - Artificial General Intelligence- AGI) و سایر فناوری های نامطمئن با پیامدهای بالقوه وجودی نیاز دارد. یک اصلاح جزیی نظارتی در برخی موارد کارساز خواهد بود. در برخی موارد دیگر، دولت ها باید رعایت مقررات را کاملا الزام آور کنند.

همه اینها مستلزم درک عمیق و دانش به روز فناوری های مورد نظر است. وضع کنندگان مقررات و سایر مسیولین به نظارت مدل های کلیدی هوش مصنوعی و دسترسی به آنها نیاز دارند. در واقع، آنها به یک سیستم بازرسی نیاز خواهند داشت که نه تنها تواناییها را از راه دور ردیابی کند، بلکه مستقیماً به فناوریهای اصلی دسترسی داشته باشند، و این به نوبه خود مستلزم داشتن دانش مناسب است. تنها چنین اقداماتی میتواند تضمین کند که هم برای خطرات آشکار و هم برای پیامدهای بالقوه مخرب درجه دوم و سوم، کاربردهای جدید هوش مصنوعی به طور فعال ارزیابی میشوند. به عبارت دیگر، مدیریت هدفمند باید مدیریت آگاهانه باشد.

الزامات پیشگیرانه فنی

بر اساس این اصول باید حداقل سه سیستم مدیریت هوش مصنوعی با وظایف، اهرمها و شرکتکنندگان متفاوت وجود داشته باشند. همه باید از نظر طراحی بدیع باشند، اما هر کدام میتوانند به دنبال الهام گرفتن از ترتیبات موجود برای پرداختن به سایر چالشهای جهانی، از قبیل تغییرات آب و هوایی، تکثیر تسلیحات و ثبات مالی باشند.

سیستم اول بر حقیقتیابی تمرکز میکند و در قالب یک نهاد علمی جهانی است که به طور عینی به دولتها و نهادهای بینالمللی درباره مسائل اساسی مانند اینکه هوش مصنوعی چیست و چه نوع چالشهایی در رابطه با سیاست ایجاد میکند، مشاوره میدهد. اگر دولتها و نهادهای بینالمللی نتوانند در مورد تعریف هوش مصنوعی یا دامنه احتمالی آسیب های ناشی از آن توافق کنند، سیاست گذاری موثر غیرممکن خواهد بود. در اینجا تغییرات آب و هوایی آموزنده است. برای تدوین پایه ای از دانش مشترک برای مذاکرات تغییرات آب و هوایی، سازمان ملل متحد پانل بین دولتی تغییرات آب و هوایی (Intergovernmental Panel on Climate Change (IPCC)) را ایجاد و به آن وظیفه ارایه دادن "ارزیابی منظمی از مبنای علمی تغییرات آب و هوا، تأثیرات آن و خطرات آتی، و گزینه ها برای تعدیل و کاهش آنها" به سیاست گذاران داد. برای ارزیابی منظم از وضعیت هوش مصنوعی، ارزیابی بیطرفانه خطرات و اثرات بالقوه آن، پیشبینی سناریوها و در نظر گرفتن راهحلهای فنی برای حفاظت از منافع عمومی جهانی، به یک نهاد مشابه نیاز هست. مانند IPCC، این نهاد نیز دارای استقلال علمی و ژئوپلیتیکی جهانی خواهد بود و همانطور که گزارشهای IPCC مذاکرات آب و هوایی سازمان ملل منعکس میکنند، گزارشهای این نهاد نیز میتوانند به مذاکرات چندجانبه در مورد هوش مصنوعی کمک کنند.

جهان همچنین به راه حلی برای مدیریت تنشها بین قدرتهای اصلی هوش مصنوعی و جلوگیری از تکثیر سیستمهای خطرناک هوش مصنوعی پیشرفته نیاز دارد. مهمترین رابطه بین المللی در رابطه با هوش مصنوعی رابطه بین ایالات متحده و چین است. دستیابی به همکاری بین دو رقیب در بهترین شرایط دشوار است. اما در زمینه رقابت حاد ژئوپلیتیکی، یک مسابقه هوش مصنوعی کنترل نشده می تواند تمام امیدها برای ایجاد یک اجماع بین المللی در مورد مدیریت هوش مصنوعی را از بین ببرد. یکی از زمینههایی که واشنگتن و پکن ممکن است همکاری با یکدیگر را مفید بدانند، کند کردن گسترش سیستمهای قدرتمندی است که میتوانند اقتدار دولت-ملت ها را به خطر بیندازند. در نهایت، تهدید AGI های کنترل نشده و خود تکثیر شونده، اگر در سال های آینده اختراع شوند، انگیزه های قوی برای هماهنگی در مورد تضمین ایمنی و مهار ایجاد می کند.

در تمام این جبههها، واشنگتن و پکن باید به دنبال ایجاد زمینه های مشترک و حتی پیشگیری هایی باشند که توسط دیگران پیشنهاد میشوند. در این زمینه، رویکردهای نظارت و راستیآزمایی که اغلب در سیستمهای کنترل تسلیحات اعمال میشوند ممکن است برای مهمترین داده های هوش مصنوعی، بهویژه دادههای مربوط به سختافزار محاسباتی، از جمله نیمهرسانه های پیشرفته و مراکز داده ها، اعمال شوند. مدیریت نقاط افتراق کلیدی به مهار یک مسابقه تسلیحاتی خطرناک در طول جنگ سرد کمک کرد و میتواند در حال حاضر به مهار یک مسابقه هوش مصنوعی حتی خطرناکتر کمک کند.

اما از آنجایی که بیشتر حوزه های هوش مصنوعی در حال حاضر غیرمتمرکز است، خود به یک مشکل مشترک جهانی تبدیل شده است تا مشکل دو ابرقدرت. ماهیت انتقالی توسعه هوش مصنوعی و ویژگیهای اصلی این فناوری، مانند تکثیر مرجع در دسترس، این احتمال را افزایش میدهد که توسط مجرمان سایبری، بازیگران تحت حمایت دولتها و افراد تبدیل به سلاح شود. به همین دلیل است که جهان به یک سیستم مدیریت سوم هوش مصنوعی نیاز دارد که بتواند در هنگام بروز اختلالات خطرناک واکنش نشان دهد. سیاستگذاران ممکن است به رویکردی نگاه کنند که مقامات مالی برای حفظ ثبات مالی جهانی استفاده کردهاند. هیئت مدیره ثبات مالی، متشکل از بانکهای مرکزی، وزارتهای دارایی، و مقامات نظارتی و مدیریتی از سراسر جهان، برای جلوگیری از بیثباتی مالی جهانی با ارزیابی آسیبپذیریهای سیستمی و هماهنگی اقدامات لازم برای رفع آنها و انعکاس آنها بین مقامات ملی و بینالمللی تلاش میکند. یک نهاد تکنوکراتیک مشابه برای مدیریت ریسک هوش مصنوعی - که میتوان آن را هیئت ثبات ژئوتکنولوژی (Geotechnology Stability Board) نامید - می تواند برای حفظ ثبات ژئوپلیتیکی در زمانه تغییرات سریع مبتنی بر هوش مصنوعی کار کند. این هییت، با حمایت مقامات نظارتی بومی دولتها و نهادهای نظارتی استاندارد بینالمللی، تخصص ها و منابع را برای پیشگیری یا پاسخگویی به بحرانهای مرتبط با هوش مصنوعی جمعآوری میکند و خطر انتشار آن را کاهش میدهد. و در عین حال، با توجه به اینکه بازیگران کلیدی فناوری چندملیتی نقش مهمی در حفظ ثبات ژئوپلیتیکی ایفا می کنند، مستقیماً با بخش خصوصی تعامل می کند، درست همانطور که بانک های مهم بطور سیستماتیک برای حفظ ثبات مالی ااقدام میکنند.

چنین نهادی، با قدرتی که ریشه در حمایت دولت دارد، میتواند به خوبی از مشارکت بازیگران فناوری جهانی در سهام بازی یا پنهان شدن در پشت شرکتها جلوگیری کند. تشخیص اینکه برخی از شرکت های فناوری از نظر سیستمی مهم هستند به معنای به حاشیه بردن استارت آپ ها یا نوآوران نوظهور نیست. برعکس، ایجاد یک رابطه واحد و مستقیم بین نهاد مدیریتی جهانی با این غولهای فناوری، اثربخشی اجرای مقررات و مدیریت بحران را افزایش میدهد – که هر دو به نفع کل اکوسیستم هستند.

ساختاری که برای حفظ ثبات ژئوتکنولوژیکی طراحی شده است، همچنین میتواند خلأ خطرناک مسئولیت مدیریت هوش مصنوعی مرجع در دسترس را در چشمانداز نظارتی کنونی پر کند. سطحی از بازبینی (نظارت) آنلاین ضروری خواهد بود. اگر کسی یک مدل بسیار خطرناک را آپلود کند، این سازمان باید دارای اختیار و توانایی کافی باشد که آن را حذف کند یا مقامات بومی را برای انجام این کار هدایت کند و این زمینه دیگری برای همکاری بالقوه دوجانبه است. چین و ایالات متحده باید برای تعبیه محدودیتهای ایمنی در نرمافزارهای مرجع در دسترس، به عنوان مثال، با محدود کردن میزانی که مدلها میتوانند به کاربران در مورد چگونگی توسعه سلاحهای شیمیایی یا بیولوژیکی یا ایجاد پاتوژنهای (pathogen - یک باکتری، ویروس یا میکروارگانیسم دیگر که می تواند باعث بیماری شود) همهگیر آموزش دهند، با یکدیگر همکاری کنند. علاوه بر این، ممکن است فضایی برای پکن و واشنگتن برای همکاری در تلاشهای جهانی ضد اشاعه، از جمله از طریق استفاده از ابزارهای سایبری مداخله جویانه وجود داشته باشد.

هر یک از این سیستم ها باید به طور جهانی عمل کنند و از مشارکت همه بازیگران اصلی هوش مصنوعی بهره مند شوند. سیستم ها باید به اندازه کافی تخصص داشته باشند تا بتوانند با سیستم های هوش مصنوعی واقعی کنار بیایند و به اندازه کافی پویا باشند تا دانش خود را در مورد هوش مصنوعی در حین تکامل به روز کنند. این موسسات با همکاری یکدیگر می توانند گامی تعیین کننده به سمت مدیریت فنی پیشگیرانه در دنیای نوظهور هوش مصنوعی بردارند. اما آنها به هیچ وجه تنها نهادهایی نیستند که مورد نیاز خواهند بود. مکانیسمهای نظارتی دیگری مانند استانداردهای شفافیت «مشتری خود را بشناسید - know your customer»، الزامات مجوز، پروتکلهای تست ایمنی، و فرآیندهای ثبت و تأیید محصول، باید در چند سال آینده برای هوش مصنوعی اعمال شوند. کلید همه این ایده ها ایجاد نهادهای مدیریتی انعطاف پذیر و چندوجهی خواهد بود که توسط سنت یا فقدان قدرت خلاقه محدود نشده باشند. در نهایت، فناوران توسط این موانع محدود نخواهند شد.

بهترین ها را تبلیغ و ترویج کنید، از بدترین ها جلوگیری کنید

اجرای هیچ یک از این راه حل ها آسان نخواهد بود. علیرغم همه هیاهوها و صحبت هایی که از سوی رهبران جهان در مورد نیاز به تنظیم هوش مصنوعی به گوش میرسد، هنوز اراده سیاسی برای انجام این کار وجود ندارد. در حال حاضر، تعداد کمی از حوزههای قدرتمند حامی هوش مصنوعی هستند و همه انگیزهها به ادامه انفعال اشاره دارند. یک سیستم مدیریتی هوش مصنوعی از نوع توصیف شده در اینجا، اگر به خوبی طراحی شود، میتواند برای همه طرفهای ذینفع مناسب باشد، و اصول و ساختارهایی را که بهترینها را تبلیغ و ترویج میکنند و در عین حال از بدترینها جلوگیری میکنند، رعایت کند. هوش مصنوعی غیرقابل کنترل به مثابه جایگزین، نه تنها خطرات غیرقابل قبولی برای ثبات جهانی ایجاد می کند، بلکه برای تجارت هم بد خواهد بود و با منافع ملی هر کشور هم مغایرت دارد.

یک ساختار مدیریتی قوی هوش مصنوعی هم خطرات اجتماعی ناشی از هوش مصنوعی را کاهش میدهد و هم تنشهای بین چین و ایالات متحده را با کاهش میزان تبدیل شدن هوش مصنوعی به عرصه و ابزار رقابت ژئوپلیتیکی کاهش میدهد. چنین ساختاری، به الگویی برای نحوه رسیدگی به سایر فناوریهای مخرب و نوظهور، به مثابه موردی دامنه دارتر، دست می یابد. هوش مصنوعی ممکن است یک کاتالیزور منحصر به فرد برای تغییر باشد، اما به هیچ وجه آخرین فناوری مخربی نیست که بشریت با آن مواجه خواهد شد. محاسبات کوانتومی، بیوتکنولوژی، نانوتکنولوژی و رباتیک نیز پتانسیل تغییر اساسی جهان را دارند. مدیریت موفقیتآمیز هوش مصنوعی به جهان کمک میکند تا این فناوریها را نیز با موفقیت اداره کند.

قرن بیست و یکم چالشهای اندکی بهاندازه چالشهای دلهرهآور یا فرصتهای امیدوارکننده ارائهشده توسط هوش مصنوعی ایجاد خواهد کرد. در قرن گذشته، سیاستگذاران شروع به ایجاد یک ساختار مدیریتی جهانی کردند که امیدوار بودند جوابگوی نیاز دوران باشد. اکنون، آنها باید یک ساختار مدیریتی جدید ایجاد کنند تا مهیب ترین، و بالقوه تعیین کننده ترین نیروی این دوران را مدیریت و مهار کند. سال 2035 نزدیک است. هیچ زمانی برای هدر دادن وجود ندارد.

IAN BREMMER رئیس و بنیانگذار گروه Eurasia و GZERO Media است. او نویسنده کتاب «قدرت بحران: چگونه سه تهدید-و پاسخ ما- جهان را تغییر خواهند داد» است.

مصطفی سلیمان مدیرعامل و یکی از بنیانگذاران هوش مصنوعی Inflection است. او که یکی از بنیانگذاران DeepMind است، نویسنده کتاب The Coming Wave: Technology, Power, and the Twenty-Ist Century’s Greatest Dilemma است.

دیدگاهها

آنقدربحث گسترده وبازاست که به همان اندازه مقاله وشایدبیشترحرف داشته باشد.امایکی ازاندیشمندان که به گمانم مارکس باشدمیگویداگرکشوری توانست حداقل معیشت مردمش رادرداخل فراهم کنددرتوازن قرارداردواگرواردکندفقیراست.فرض کنیم کشوری داریم که درهرده قدم یک دوربین داردواینترنت رایگان دراختیارهمه است.تمام وسائل برقی هوشمندوتمام ارتباطات ازآخرین تکنولوژی الکترونیکی استفاده میکننداما هیچ معنای خوشبختی آن جامعه رانمیدهد.ممکن است درنهایت فقرواستثمارباشندوبرای نان شب محتاج.اگرهوش مصنوعی درخدمت رفاه جامعه نباشدغیراززنجیرهای پیچیده تراستثمارچیزدیگری نیست.حال ابرقدرتها موشکی بسازندقاره پیماکه فقط یکنفرمخصوص رابزند.این سودی برای بشریت ندارد.اگرستم انسان برانسان نبودتکنولوژی هزاربارازاین بهتروموثرتربرای انسان وجودداشت.وقتی کلیدبرق رامیزنی ویک لامپ روشن میشودیک استادفیزیک فقط دوساعت میتواندراجع به این اتفاق صحبت کند.تشریح یک موبایل حتما سالهاوقت میبرد.بنده به به خدا نشویم که چه هوش مصنوعی بالایی .کاربردی وتازه آنهم مردمی نگاه گنیم.

موبایل ورایانه رامیتوان قیاسی برای هوش مصنوعی گرفت .هوش مصنوعی بیشترین خدمتش درحوزه خدمات است.ملیاردها اطلاعات که ایجادکنیدتاشکم مردم وحتا همان سلیکون ولی سیرنشودبی فایده خواهدبود.نه اینکه بی تاثیرباشددریهبودزندگی انسان اما همین اینترنت ماهانه چقدرازجیب مردم خالی میکند.قویترین کامپیوتردنیا هم عمری دارد.سودراکه میکندهمان سازنده.حتا کدهای اپن سورس هم دروغ است بازهم هسته اصلی دست همان قدرت های ناپیداست.این وسط دستمزدکارگربه تمیزترین شکل جارومیشود.همین دستگاه های فعلی راقیاسی برهوش مصنوعی آینده بگیرید.تاتولیدبرای زندگی حداقل دوباره انسانوحوایج روزانه آن به حدکافی نباشدوخیل عظیم گرسنگان همچنان باشندهوش مصنوعی فقط به گسترش فقردامن میزند

افزودن دیدگاه جدید